Imaginez un monde où presque quatre jeunes sur cinq se tournent vers l’intelligence artificielle pour les aider dans leurs études. Selon une récente enquête de Diplomeo, c’est exactement ce qui se passe : 78 % des 16-25 ans utilisent des outils basés sur l’IA pour naviguer à travers leurs parcours éducatifs, avec 25 % d’entre eux qui s’y fient chaque semaine. Mais cette facilité d’accès à l’information soulève des préoccupations, surtout parmi les enseignants qui redoutent que les devoirs rendus ne soient plus l’œuvre des étudiants eux-mêmes, mais plutôt celle d’une machine.

Parmi ces jeunes utilisateurs, 35 % admettent même rédiger tout ou partie de leurs travaux grâce à des plateformes comme ChatGPT. Ici, les détecteurs d’IA deviennent cruciaux pour démêler le vrai du faux. Mais peut-on vraiment compter sur ces outils pour distinguer un texte écrit par un humain de celui généré par une machine ?

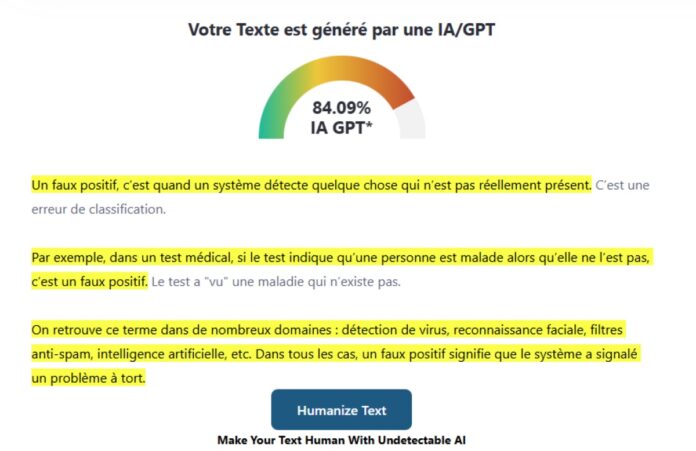

Ces détecteurs, souvent basés sur des modèles de langage similaires à ceux utilisés pour générer du contenu, ne fournissent qu’une estimation probabiliste. Autrement dit, le pourcentage donné par le détecteur n’est qu’une approximation de la probabilité qu’un texte soit le fruit d’une IA. Si un texte présente des similitudes avec le style typique d’un modèle d’IA, ou s’il manque de ces petites imperfections grammaticales ou orthographiques qui trahissent souvent une main humaine, il pourrait être marqué comme suspect.

Le hic, c’est que ces outils ne sont pas infaillibles. Les faux positifs abondent, surtout lorsque le texte suit des schémas très structurés typiques des introductions ou des conclusions d’essais académiques. Des phrases comme « comme nous avons pu le voir » ou « pour conclure, nous pouvons affirmer que » peuvent être incorrectement signalées comme étant l’œuvre d’une IA.

Et que dire des contenus qui, bien que simples et logiques, comme « Nos parents attendent devant le gymnase que nous sortions de notre séance de sport », pourraient être jugés comme non humains simplement parce qu’ils suivent une logique prévisible ? D’un autre côté, une phrase plus imprévisible et complexe a moins de chances d’être faussement identifiée comme générée par IA.

Face à ces défis, la fiabilité des détecteurs d’IA reste en question. Bien qu’ils s’améliorent, se fier entièrement à eux pour juger de l’authenticité d’un travail académique est encore risqué. Dans le domaine de l’éducation, cela pose un sérieux dilemme : comment sanctionner un travail soupçonné d’être l’œuvre d’une IA sans preuve concrète ?

Finalement, cette situation ouvre une boîte de Pandore éthique et pratique. Devrions-nous commencer à valoriser les fautes d’orthographe comme preuve d’authenticité humaine ? Ou devons-nous trouver de meilleures méthodes pour intégrer l’IA dans l’éducation tout en préservant l’intégrité académique ?

La question reste ouverte, et la conversation ne fait que commencer. Quelles sont vos réflexions sur l’utilisation de l’IA dans les études ? Pensez-vous que les écoles devraient adopter des politiques spécifiques pour cette nouvelle ère numérique ?